Robots txt - Consejos para comunicarte con Google gracias a este archivo

El fichero robots.txt es muy necesario en cuanto a SEO. Se usa para comunicarnos con los motores de búsqueda, a los que nos referiremos también como “la araña de Google” o robots a secas, de ahí el nombre del fichero.

Los motores de búsqueda, como ya sabemos, son los encargados de analizar todas y cada una de las páginas web que existen en Internet y añadirlas a su índice, el cuál las ordena en base a su algoritmo para mostrar los resultados de búsqueda en un sentido determinado u otro.

Robots txt - Consejos para comunicarte con Google gracias a este archivo

¿Qué es el fichero robots txt y para qué se usa?

El fichero robots.txt debe estar en la raíz del dominio. Permite comunicarle a la araña de Google los directorios o páginas que queremos indexar y los que no. También se usa para especificar la ubicación del archivo sitemap.xml que veremos a continuación.

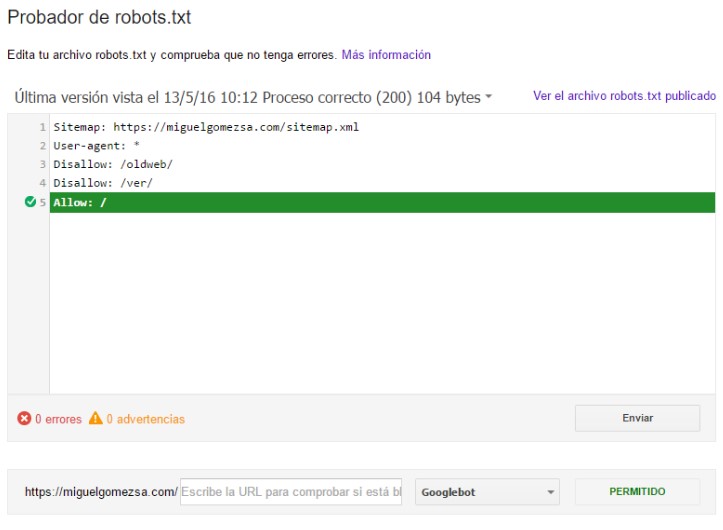

Este puede ser el contenido de un archivo robots.txt muy común, en el que indicamos la localización exacta de nuestro sitemap.xml, e indicamos que cualquier robot puede indexar todo nuestro contenido:

Tiene una estructura sencilla.

- En primer lugar se indica donde está el sitemap del sitio web.

- En segundo lugar el agente, cualquier dispositivo al que va dirigido la siguiente orden.

- Por último se indica si se permite el acceso o no, y la ruta específica.

Sitemap: http://miguelgomezsa.com/sitemap.xml

User-agent: *

Allow: /

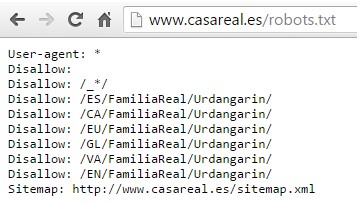

Como curiosidad aquí tenemos una imagen del robots.txt de la web de la casa real:

Estos archivos tienen un inconveniente, y es que en caso de una página enlazada desde un sitio web indexado en Google, probablemente nuestra página también será indexada aunque la hayamos puesto en “Disallow” dentro de nuestro robots.txt. Con esto quiero decir que el fichero robots.txt no es tampoco fiable al 100%., y para asegurarnos de que no se indexen algunos directorios deseados debemos usar otras técnicas más efectivas, como la autenticación por medio de .htaccess.

Primer consejo para tener un buen robots.txt

Si tienes dudas en qué indexar y qué no. Indéxalo todo.

Otro consejo muy bueno es..

Tener siempre disponible y accesible el robots.txt, con el siguiente contenido, lo cual permitirá que se indexe todo

User-agent: *

Allow: /

El último consejo para usar bien el archivo robots

En el archivo robots puedes indicar todos los archivos sitemaps de tu web. Asegúrate de tenerlos todos dentro.

Puedes asegurarte de que el motor de búsqueda de Google puede acceder a su sitio web usando la funcionalidad “Rastreo” > “Probador de robots.txt” en Google Search Console.

Como permitir y rechazar que un robot indexe nuestra web con Allow y Disallow en robots.txt

Fácilmente, y lo vamos a ver con varios ejemplos claros. En el siguiente le decimos a Google que no idexe el directorio panel. Aunque como hemos dicho antes no es 100 % seguro de que así sea.

User-agent: Googlebot

Disallow: /panel/

El ejemplo contrario seria el siguiente:

User-agent: * Disallow: /

Resumiendo sobre el robots txt

El principal uso que se le suelen dar al robots txt es el de excluir a algunos motores de búsqueda para que no indexen cierto contenido. Pero debes tener en cuenta que aunque bloques páginas de cara a los robots de búsqueda, todavía pueden indexarse si hay enlaces externos a éstas desde otros sitios web.

La única forma de evitar al 100 % que un motor de búsqueda no indexe cierto contenido es protegerlo mediante contraseña.

También se suele usar la meta etiqueta noindex, aunque al igual que el archivo robots.txt no es de una efectividad del 100%.

Ejemplo de archivo robots txt de una web cualquiera

User-agent: * Disallow:/admin/ Disallow:/panel/ Disallow:/wp-admin* Disallow:/?buscar Disallow:/? Disallow:/?* Disallow:/autores/ Disallow:/categoria/prohibida/ Disallow:/portal2/ Disallow:/old/ Disallow:/2017/ Disallow:/no-entrar/ Disallow:/buscar/buscar.php?texto=<a href="">hola</a>

Más información sobre el archivo robots en: https://developers.google.com/search/reference/robots_txt?hl=es

Si aún tienes dudas de cómo funciona el archivo robots, deja un comentario, estaré encantado de poder ayudarte.